共计 2740 个字符,预计需要花费 7 分钟才能阅读完成。

主要特性

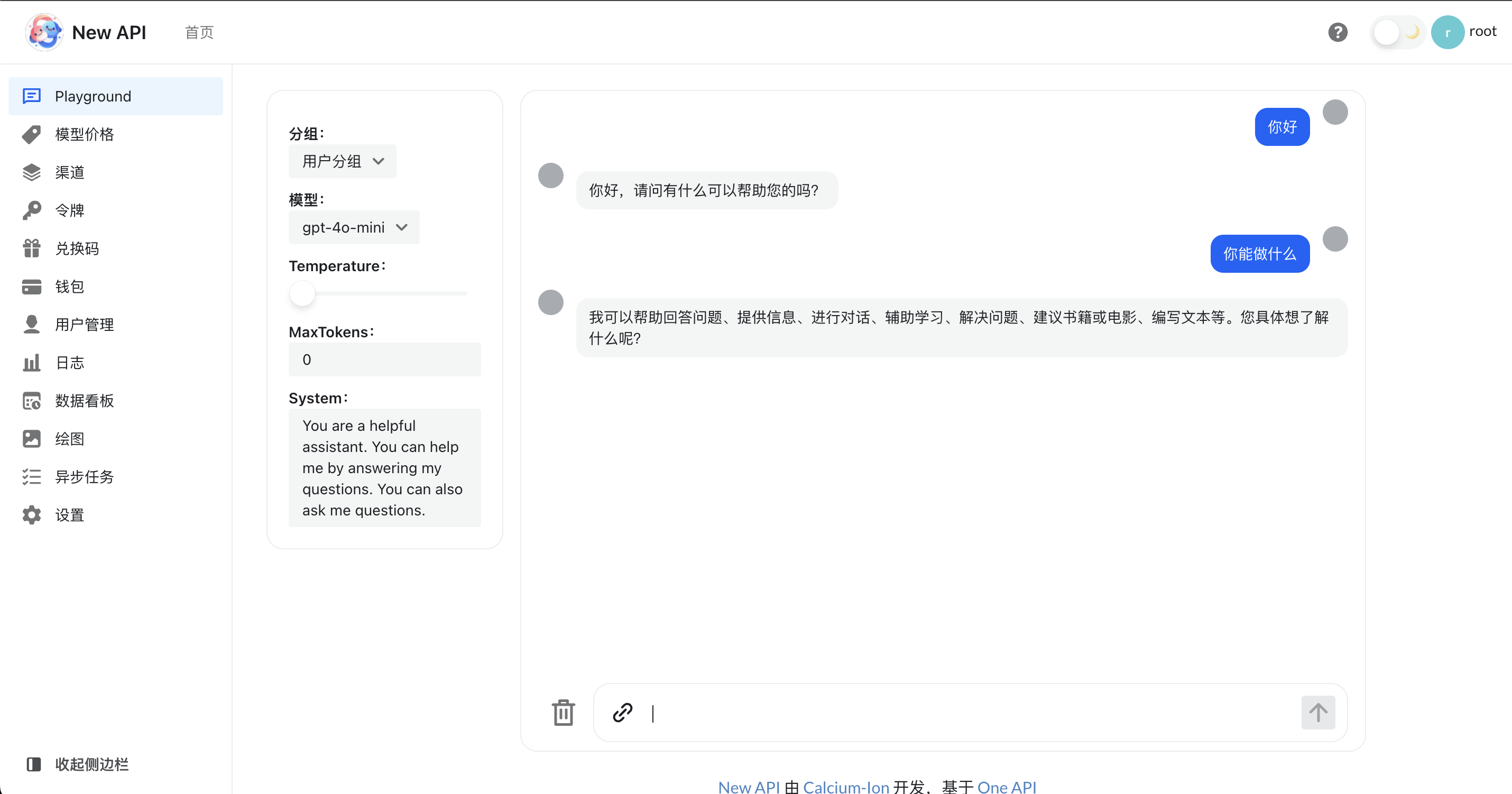

- 🎨 全新的 UI 界面(部分界面还待更新)

- 🌍 多语言支持(待完善)

- 🎨 添加 Midjourney-Proxy(Plus)接口支持

- 💰 支持在线充值功能,可在系统设置中设置:

- 易支付

- 🔍 支持用 key 查询使用额度:

- 配合项目 neko-api-key-tool 可实现用 key 查询使用

- 📑 分页支持选择每页显示数量

- 🔄 兼容原版 One API 的数据库,可直接使用原版数据库(one-api.db)

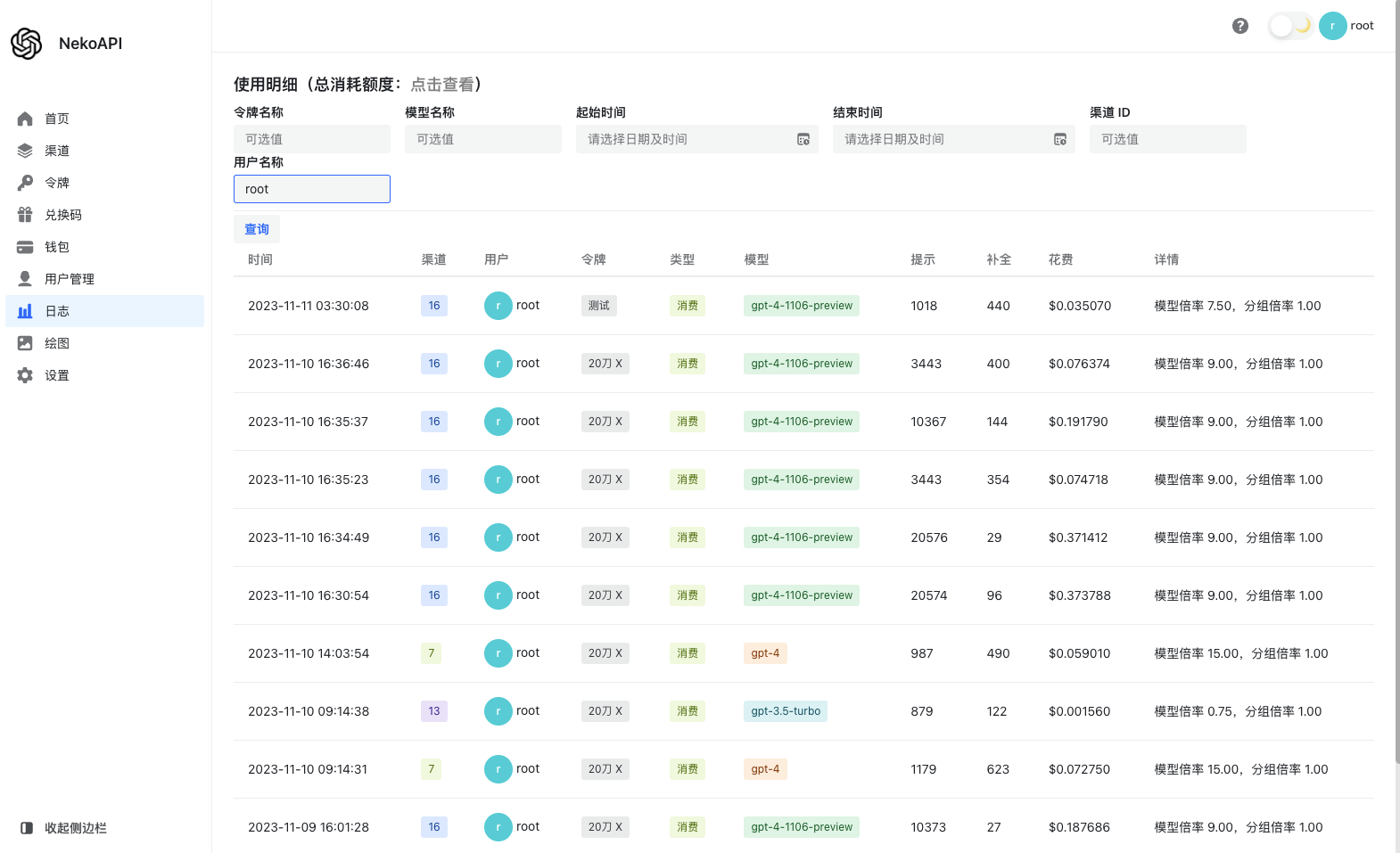

- 💵 支持模型按次数收费,可在 系统设置 - 运营设置 中设置

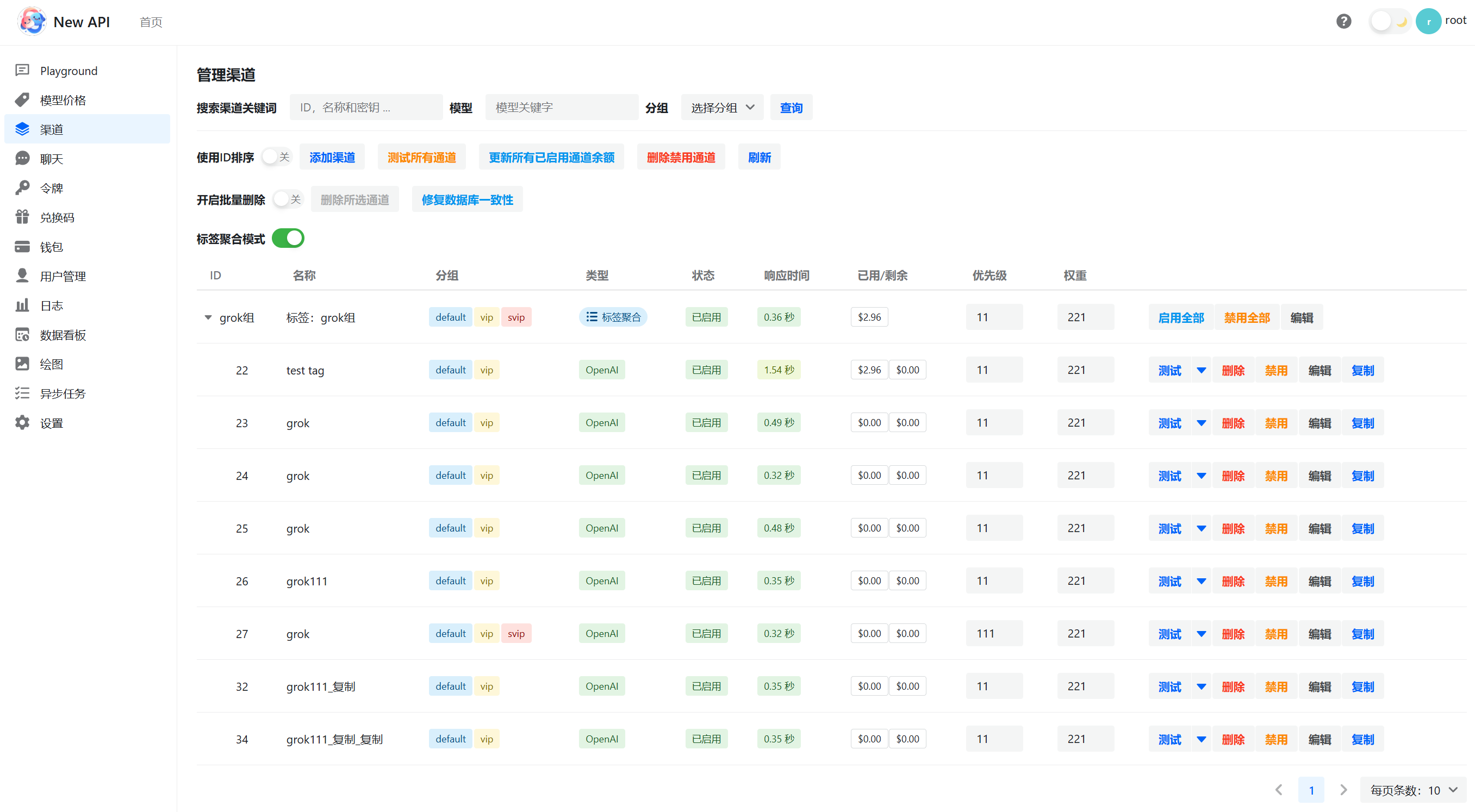

- ⚖️ 支持渠道 加权随机

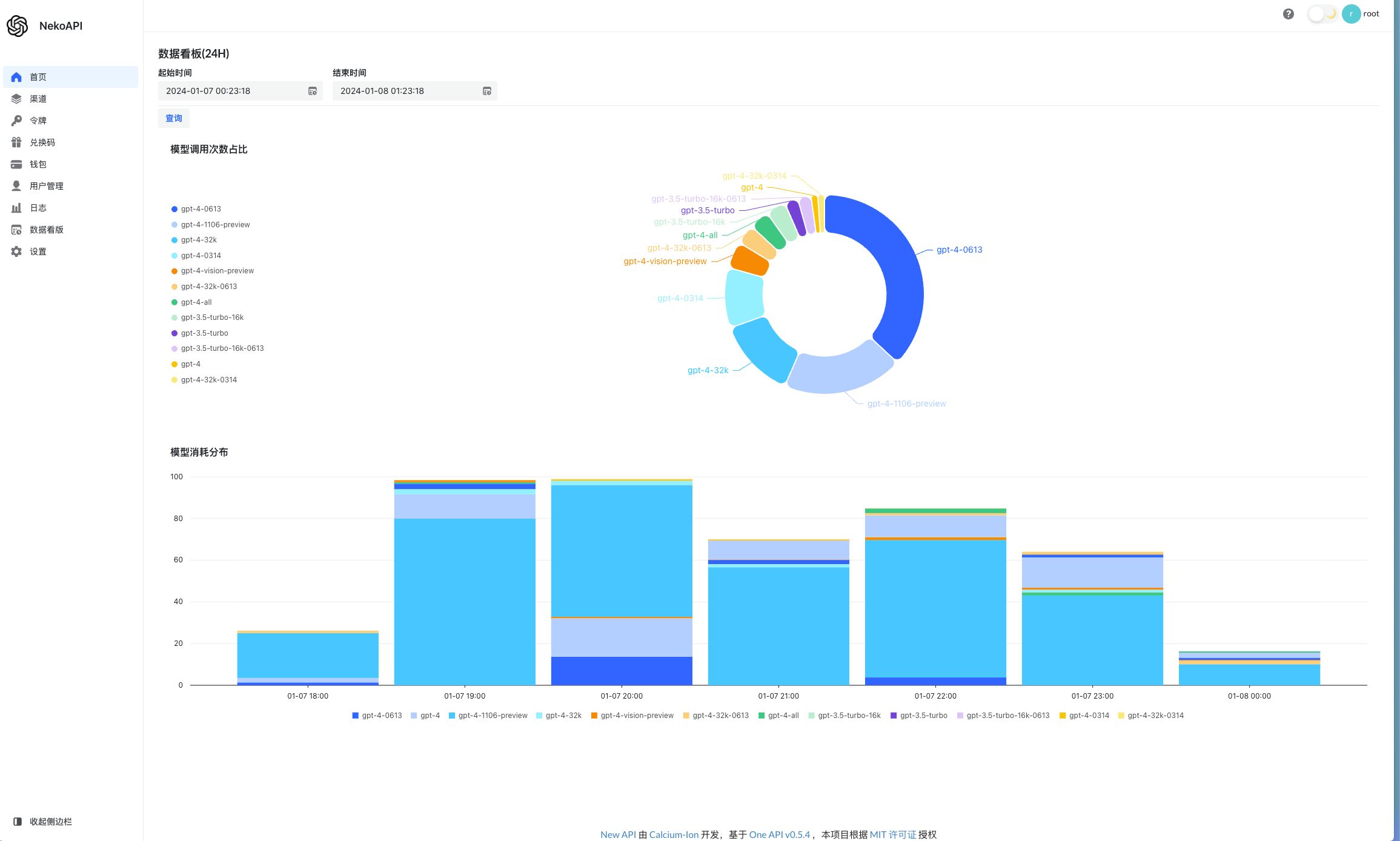

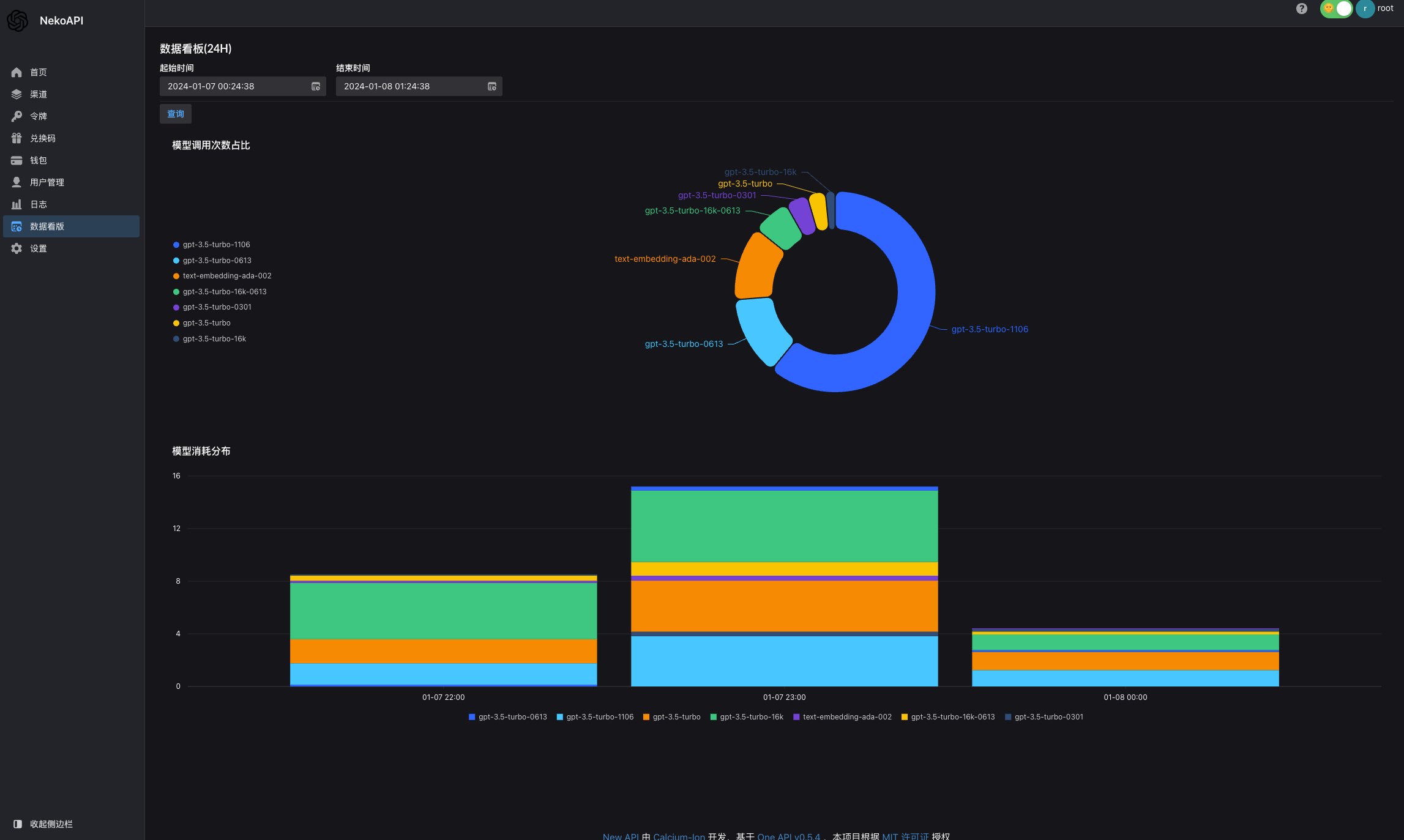

- 📈 数据看板(控制台)

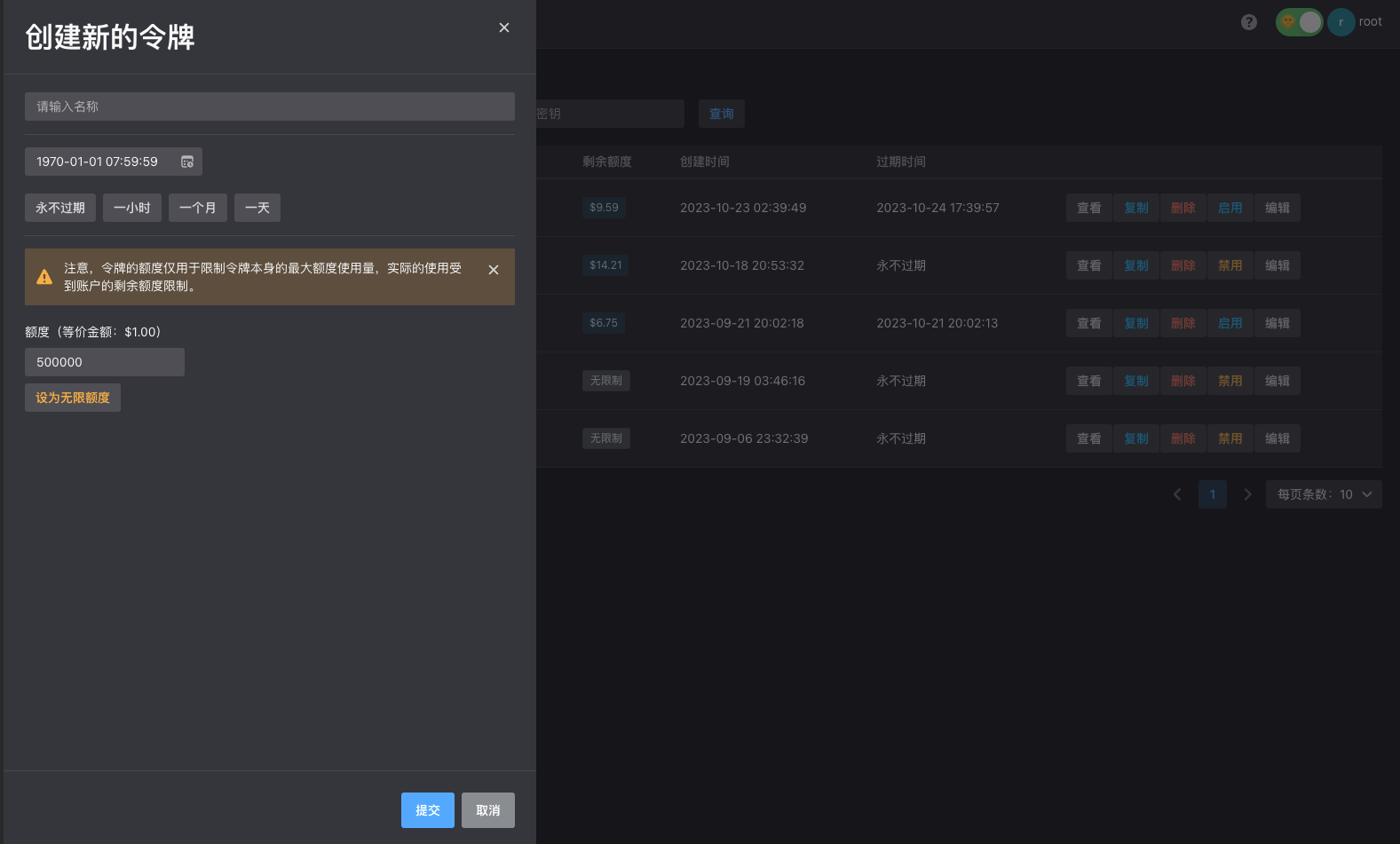

- 🔒 可设置令牌能调用的模型

- 🤖 支持 Telegram 授权登录:

- 系统设置 - 配置登录注册 - 允许通过 Telegram 登录

- 对 @Botfather 输入指令 /setdomain

- 选择你的 bot,然后输入 http(s):// 你的网站地址 /login

- Telegram Bot 名称是 bot username 去掉 @后的字符串

- 🎵 添加 Suno API 接口支持

- 🔄 支持 Rerank 模型,目前兼容 Cohere 和 Jina,可接入 Dify

- ⚡ OpenAI Realtime API – 支持 OpenAI 的 Realtime API,支持 Azure 渠道

- 支持使用路由 /chat2link 进入聊天界面

此版本额外支持以下模型:

- 第三方模型 gps(gpt-4-gizmo-*)

- Midjourney-Proxy(Plus)接口

- 自定义渠道,支持填入完整调用地址

- Suno API 接口

- Rerank 模型,目前支持 Cohere 和 Jina

- Dify

您可以在渠道中添加自定义模型 gpt-4-gizmo-*,此模型并非 OpenAI 官方模型,而是第三方模型,使用官方 key 无法调用。

GENERATE_DEFAULT_TOKEN:是否为新注册用户生成初始令牌,默认为false。STREAMING_TIMEOUT:设置流式一次回复的超时时间,默认为 60 秒。DIFY_DEBUG:设置 Dify 渠道是否输出工作流和节点信息到客户端,默认为true。FORCE_STREAM_OPTION:是否覆盖客户端 stream_options 参数,请求上游返回流模式 usage,默认为true,建议开启,不影响客户端传入 stream_options 参数返回结果。GET_MEDIA_TOKEN:是否统计图片 token,默认为true,关闭后将不再在本地计算图片 token,可能会导致和上游计费不同,此项覆盖GET_MEDIA_TOKEN_NOT_STREAM选项作用。GET_MEDIA_TOKEN_NOT_STREAM:是否在非流(stream=false)情况下统计图片 token,默认为true。UPDATE_TASK:是否更新异步任务(Midjourney、Suno),默认为true,关闭后将不会更新任务进度。GEMINI_MODEL_MAP:Gemini 模型指定版本(v1/v1beta),使用“模型: 版本”指定,”,” 分隔,例如:-e GEMINI_MODEL_MAP=”gemini-1.5-pro-latest:v1beta,gemini-1.5-pro-001:v1beta”,为空则使用默认配置(v1beta)COHERE_SAFETY_SETTING:Cohere 模型安全设置,可选值为NONE,CONTEXTUAL,STRICT,默认为NONE。GEMINI_VISION_MAX_IMAGE_NUM:Gemini 模型最大图片数量,默认为16,设置为-1则不限制。

最新版 Docker 镜像:calciumion/new-api:latest

默认账号 root 密码 123456

更新指令:

docker run --rm -v /var/run/docker.sock:/var/run/docker.sock containrrr/watchtower -cR

部署要求

- 本地数据库(默认):SQLite(Docker 部署默认使用 SQLite,必须挂载

/data目录到宿主机) - 远程数据库:MySQL 版本 >= 5.7.8,PgSQL 版本 >= 9.6

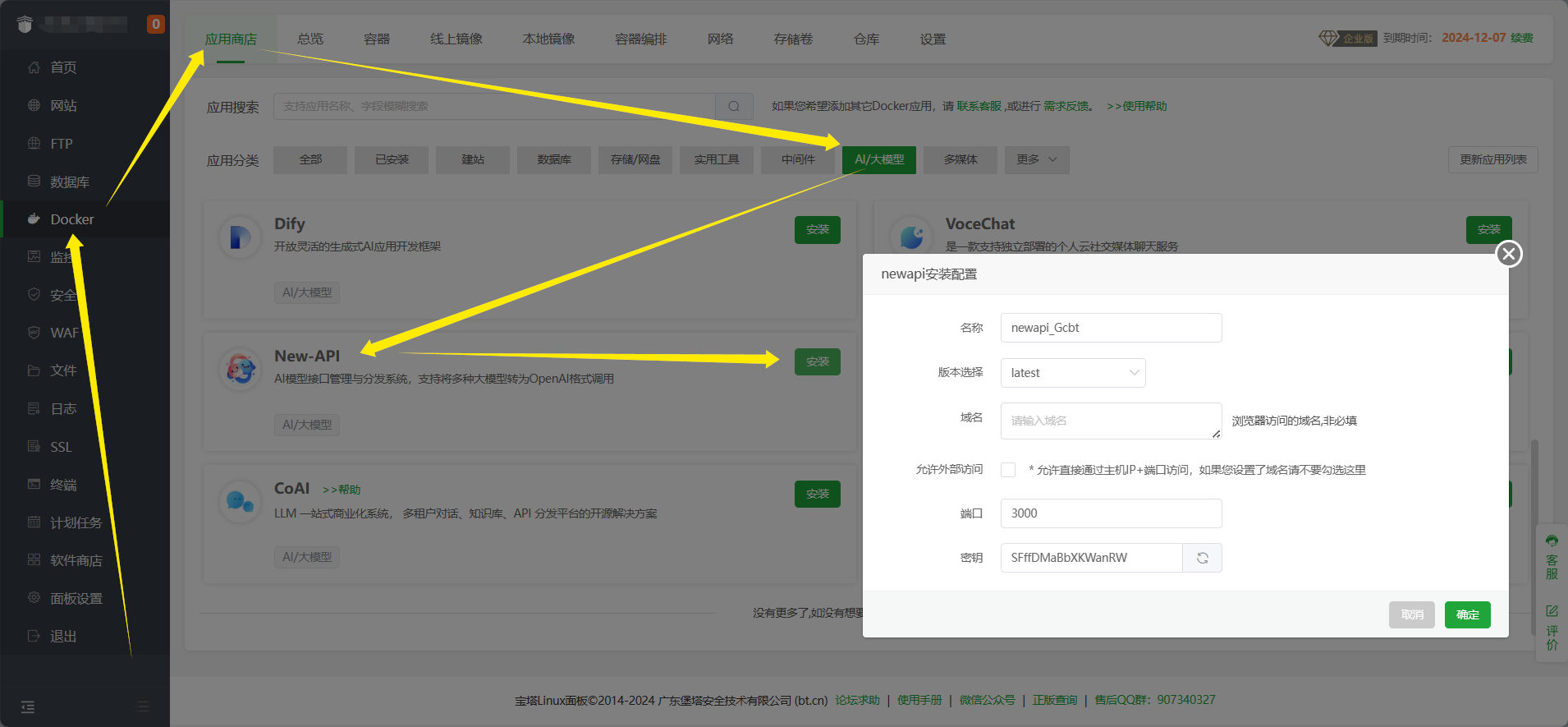

安装宝塔面板 (9.2.0 版本 及以上),前往 宝塔面板 官网,选择正式版的脚本下载安装

安装后登录宝塔面板,在菜单栏中点击 Docker,首次进入会提示安装 Docker 服务,点击立即安装,按提示完成安装

安装完成后在应用商店中找到 New-API,点击安装,配置基本选项 即可完成安装

# 下载项目

git clone https://github.com/Calcium-Ion/new-api.git

cd new-api

# 按需编辑 docker-compose.yml

# 启动

docker-compose up -d# 使用 SQLite 的部署命令:

docker run --name new-api -d --restart always -p 3000:3000 -e TZ=Asia/Shanghai -v /home/ubuntu/data/new-api:/data calciumion/new-api:latest

# 使用 MySQL 的部署命令,在上面的基础上添加 `-e SQL_DSN="root:123456@tcp(localhost:3306)/oneapi"`,请自行修改数据库连接参数。

# 例如:

docker run --name new-api -d --restart always -p 3000:3000 -e SQL_DSN="root:123456@tcp(localhost:3306)/oneapi" -e TZ=Asia/Shanghai -v /home/ubuntu/data/new-api:/data calciumion/new-api:latest渠道重试功能已经实现,可以在 设置 -> 运营设置 -> 通用设置 设置重试次数,建议开启缓存 功能。

如果开启了重试功能,第一次重试使用同优先级,第二次重试使用下一个优先级,以此类推。

REDIS_CONN_STRING:设置之后将使用 Redis 作为缓存使用。- 例子:

REDIS_CONN_STRING=redis://default:redispw@localhost:49153

- 例子:

MEMORY_CACHE_ENABLED:启用内存缓存(如果设置了REDIS_CONN_STRING,则无需手动设置),会导致用户额度的更新存在一定的延迟,可选值为true和false,未设置则默认为false。- 例子:

MEMORY_CACHE_ENABLED=true

- 例子:

正文完