共计 3023 个字符,预计需要花费 8 分钟才能阅读完成。

Open WebUI 是一个 可扩展、功能丰富且用户友好的自托管 WebUI,旨在完全离线运行。它支持各种 LLM 运行器,包括 Ollama 和 OpenAI 兼容 API。

-

🚀轻松设置 :使用 Docker 或 Kubernetes(kubectl、kustomize 或 helm)无缝安装,获得无忧体验,并支持

:ollama标记:cuda图像。 -

🤝 Ollama/OpenAI API 集成:轻松集成与 OpenAI 兼容的 API,以便与 Ollama 模型进行多种对话。自定义 OpenAI API URL 以链接到LMStudio、GroqCloud、Mistral、OpenRouter 等。

-

🛡️细粒度的权限和用户组:通过允许管理员创建详细的用户角色和权限,我们确保了安全的用户环境。这种粒度不仅增强了安全性,而且还允许定制用户体验,培养用户的主人翁意识和责任感。

-

📱响应式设计:享受台式电脑、笔记本电脑和移动设备之间的无缝体验。

-

📱适用于移动设备的渐进式 Web 应用程序 (PWA):通过我们的 PWA 在您的移动设备上享受类似原生应用程序的体验,提供本地主机上的离线访问和无缝的用户界面。

-

✒️🔢完全支持 Markdown 和 LaTeX:通过全面的 Markdown 和 LaTeX 功能提升您的 LLM 体验,实现丰富的交互。

-

🎤📹免提语音 / 视频通话:体验集成的免提语音和视频通话功能的无缝通信,从而实现更加动态和互动的聊天环境。

-

🛠️模型构建器 :通过 Web UI 轻松创建 Ollama 模型。通过Open WebUI Community 集成轻松创建和添加自定义角色 / 代理、自定义聊天元素和导入模型。

-

🐍原生 Python 函数调用工具:通过工具工作区中的内置代码编辑器支持增强您的 LLM。只需添加纯 Python 函数即可自带函数 (BYOF),从而实现与 LLM 的无缝集成。

-

📚本地 RAG 集成 :借助突破性的检索增强生成 (RAG) 支持,探索聊天交互的未来。此功能将文档交互无缝集成到您的聊天体验中。您可以将文档直接加载到聊天中或将文件添加到文档库中,使用

#查询前的命令轻松访问它们。 -

🔍 RAG 的网络搜索 :使用

SearXNG、、、、、、、、和等提供商执行网络搜索,Google PSE并将结果直接注入您的聊天体验。Brave SearchserpstackserperSerplyDuckDuckGoTavilySearchSearchApiBing -

🌐网页浏览功能

#:使用命令后跟 URL,将网站无缝集成到您的聊天体验中。此功能允许您将网页内容直接整合到您的对话中,增强互动的丰富性和深度。 -

🎨图像生成集成:使用 AUTOMATIC1111 API 或 ComfyUI(本地)以及 OpenAI 的 DALL-E(外部)等选项无缝整合图像生成功能,通过动态视觉内容丰富您的聊天体验。

-

⚙️多模型对话:轻松同时与各种模型互动,利用其独特优势获得最佳响应。通过同时利用多种模型来增强您的体验。

-

🔐基于角色的访问控制 (RBAC):通过受限的权限确保安全访问;只有授权个人才能访问您的 Ollama,并且为管理员保留独占的模型创建 / 拉取权限。

-

🌐🌍多语言支持:借助我们的国际化 (i18n) 支持,以您喜欢的语言体验 Open WebUI。

-

🧩 Pipelines、Open WebUI 插件支持:使用 Pipelines 插件框架 将自定义逻辑和 Python 库无缝集成到 Open WebUI 中。启动您的 Pipelines 实例,将 OpenAI URL 设置为 Pipelines URL,并探索无限可能。

可以使用 Python 软件包安装程序 pip 安装 Open WebUI。在继续操作之前,请确保您使用的是 Python 3.11, 以避免兼容性问题。

-

安装 Open WebUI:打开终端并运行以下命令来安装 Open WebUI:

pip install open-webui -

运行 Open WebUI:安装后,您可以通过执行以下命令启动 Open WebUI:

open-webui serve

这将启动 Open WebUI 服务器,您可以通过http://localhost:8080 访问它。

Docker使用默认配置进行安装

-

如果您的计算机上有 Ollama,请使用以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main -

如果 Ollama 位于不同的服务器上,请使用以下命令:

要连接到另一台服务器上的 Ollama,请更改

OLLAMA_BASE_URL为该服务器的 URL:docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main -

要运行支持 Nvidia GPU 的 Open WebUI,请使用以下命令:

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

-

如果您仅使用 OpenAI API,请使用此命令:

docker run -d -p 3000:8080 -e OPENAI_API_KEY=your_secret_key -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

此安装方法使用将 Open WebUI 与 Ollama 捆绑在一起的单个容器映像,从而允许通过单个命令进行简化设置。根据您的硬件设置选择适当的命令:

-

借助 GPU 支持:通过运行以下命令来利用 GPU 资源:

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama -

仅适用于 CPU:如果您不使用 GPU,请改用以下命令:

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

这两个命令都有助于 Open WebUI 和 Ollama 的内置、无忧安装,确保您可以快速启动并运行一切。

安装后,可以通过 http://localhost:3000访问 Open WebUI。

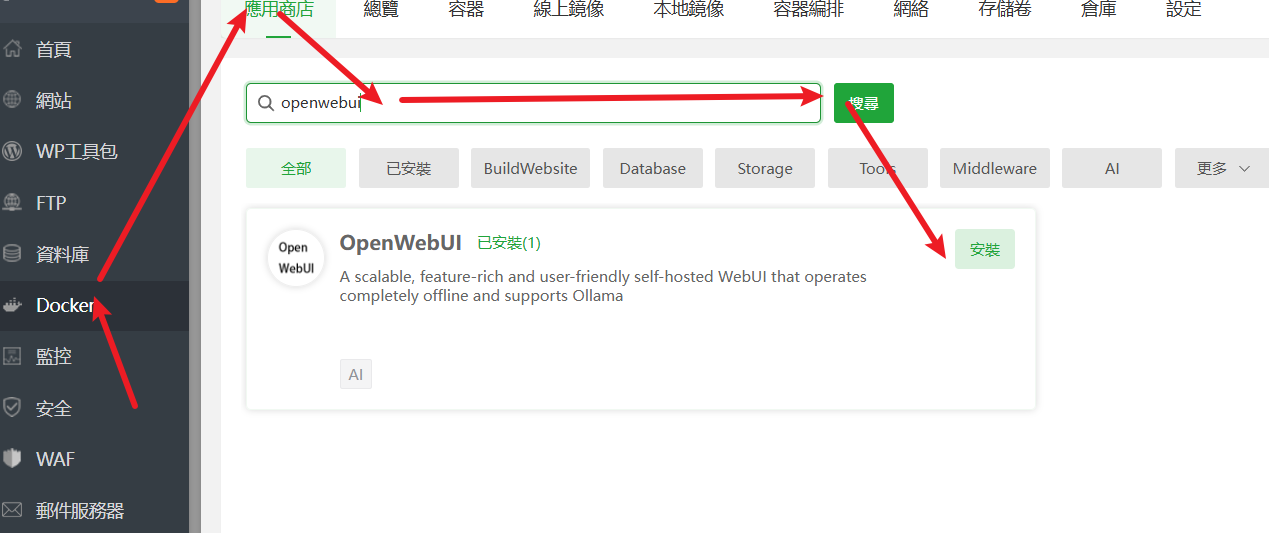

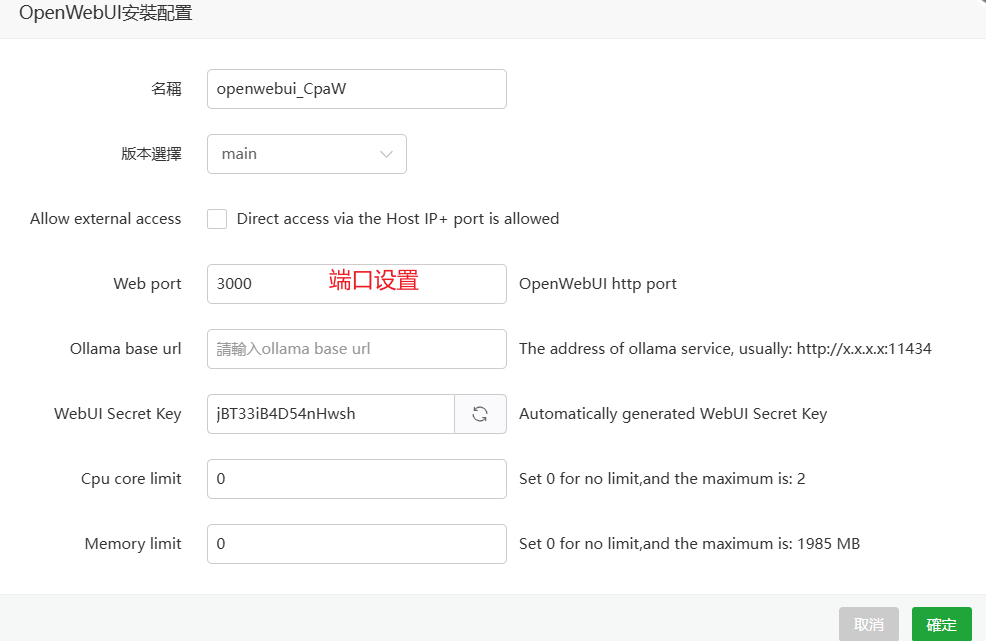

宝塔一键安装